Los guardianes de la verdad en la era de la inteligencia artificial

La inteligencia artificial y los deepfakes desafían la confianza pública en la era digital

Los guardianes de la verdad en la era de la inteligencia artificial

El código iframe se ha copiado en el portapapeles

Madrid

El año 2024 fue calificado por muchos como el año electoral más grande de la historia. Según datos de la ONG Fundación Internacional para Sistemas Electorales, a lo largo de estos últimos 12 meses se llevaron a cabo elecciones en más de 60 países, en los que estuvieron involucradas más de 3.700 millones de personas. Un 2024 en el que ha destacado el retorno de Donald Trump a la Casa Blanca, la victoria del Nuevo Frente Popular en Francia y la llegada de Claudia Sheinbaum al gobierno de México, convirtiéndose así en la primera mujer en hacerlo.

Más información

Este año también ha estado marcado por el impacto que ha tenido la tecnología en el sentido del voto de la población. Si los procesos electorales del año 2016 estuvieron marcados por el escándalo de Cambridge Analytica, pues contribuyeron directamente a victorias como la de Donald Trump en Estados Unidos o la del Brexit en Reino Unido, el 2024 nos ha enfrentado al reto de los videos, imágenes o audios generados por inteligencia artificial que emulan la apariencia y voz de una persona. Los deepfakes.

Los deepfakes se adentran en la política

Durante estos últimos 12 meses se han publicado numerosos audios, imágenes y vídeos manipulados que han intentado influenciar nuestra percepción sobre los distintos candidatos políticos de todo el mundo. En Venezuela se popularizaron numerosos vídeos falsos sobre Delsa Solórzano y Nicolás Maduro, en México se utilizó la voz de Claudia Sheinbaum con distintos fines y en Estados Unidos tanto Joe Biden como Donald Trump acabaron siendo noticia por la problemática de los deepfakes.

Ilustración de un trol de internet manipulando un mensaje político. / sonmez karakurt

Ilustración de un trol de internet manipulando un mensaje político. / sonmez karakurt

En enero de 2024, las autoridades de New Hampshire denunciaron que los votantes estaban recibiendo llamadas robóticas falsas con la voz de Joe Biden para que no acudieran a las elecciones primarias. Varios meses más tarde, Donald Trump hizo uso tanto de la inteligencia artificial como de las imágenes y vídeos falsos con el objetivo de atraer el voto de los más indecisos. Una situación que podría contribuir negativamente a la confianza de la ciudadanía tanto hacia los distintos representantes políticos como a las elecciones y a la política en general. El contenido manipulado con fines políticos no para de crecer y el riesgo de caer en la trampa es cada vez mayor.

La revolución de la inteligencia artificial

¿Por qué? Porque la inteligencia artificial crece a una velocidad vertiginosa y, con ellas, las herramientas y aplicaciones generan todo tipo de audios, imágenes y vídeos. Según Daniel Palacios del Río, Marketing Manager de Softtek, los deepfakes pueden llegar a tener un impacto profundo en la sociedad actual. Principalmente a través de tres vías como son la de la desinformación, la del fraude y la de la suplantación de identidad: "Estas tecnologías permiten crear contenido audiovisual extremadamente realista, lo que dificulta la distinción entre lo real y lo falso. Esto puede ser utilizado para propagar noticias falsas, para manipular opiniones públicas y también para influir en las elecciones tanto de individuos como de organizaciones".

Durante estos últimos años era bastante fácil distinguir una imagen real de una manipulada en base a varios detalles como podían ser las manos. Sin embargo, estas aplicaciones han ido evolucionado y corrigiendo esta serie de errores hasta el punto de ser prácticamente idénticas a las reales. Por si esto fuera poco, el uso de estas herramientas se ha generalizado y pueden ser utilizadas por cualquier persona con el peligro que esto supone: "Sin una intervención adecuada podríamos enfrentarnos a una crisis de confianza en los medios de comunicación, las redes sociales e incluso en las instituciones públicas".

Por lo tanto, nos dirigimos a una realidad en la que cada vez será más difícil distinguir un contenido real de uno generado por inteligencia artificial. De ahí que sea más necesario que nunca el desarrollo de aplicaciones que luchen en pos de la verdad y que sean capaces de ayudar a la sociedad a distinguir contenidos reales de aquellos manipulados mediante la inteligencia artificial. Un pensamiento cada vez más extendido que ha permitido la creación de todo tipo de plataformas y alianzas que tienen como objetivo revertir la situación.

Luces y sombras del protocolo C2PA

Una de ellas es la Coalición para la Procedencia y Autenticidad del Contenido (C2PA, por sus siglas en inglés), formada por algunas de las compañías tecnológicas más importantes a nivel internacional. Desde Microsoft hasta Meta pasando por otras como Google, Amazon u OpenAI, quienes trabajan de forma conjunta desde el año 2021 para encontrar una solución realista a este problema. Y tienen una idea que podría ser de gran ayuda. En su página web proponen incluir una serie de metadatos en cada contenido (audio, imagen y vídeo) para que podamos conocer su origen.

Una especie de etiqueta invisible que nos permitirá trazar el contenido que estemos consumiendo y saber quién es su responsable y qué tipo de herramientas ha utilizado durante su elaboración. ¿Cuál es su problema principal? Que requiere que todas las tecnológicas se pongan de acuerdo y que comiencen a añadir la bautizada como "información C2PA" en cada archivo. A pesar de que algunas como Adobe ya han comenzado a incorporar los estándares de la C2PA en sus productos, se trata de un reto que requiere de un consenso global al que todavía parece demasiado complicado de llegar. Principalmente por la complejidad técnica para implementar este estándar a nivel global, por los intereses comerciales que podrían frenar la colaboración o por las diferencias legales entre países.

Los retos éticos

Daniel Palacios del Río cree que es posible llegar a un acuerdo, aunque requiere de la colaboración interdisciplinaria e internacional: "Es imprescindible trabajar con un enfoque común, lo que implica la cooperación entre gobiernos, empresas tecnológicas, organizaciones internacionales y el ámbito económico". De hecho, el experto nos explica que ya se están desarrollando estándares abiertos para la autenticación de contenido digital y que algunas grandes empresas están integrando las verificaciones en sus plataformas. No obstante, la coordinación enfrenta grandes desafíos.

La mayoría de ellos de carácter ético: "En el plano ético surge la cuestión del equilibrio entre la privacidad y la seguridad. Algunas soluciones implican el uso masivos de datos personales para entrenar algoritmos que detectan deepfakes, lo que puede poner en riesgo la privacidad de los usuarios". Uno de los casos más reconocibles de esta guerra por los datos es la que enfrenta a las grande tecnológicas y a la Unión Europea por su Reglamento General de Protección de Datos (GDPR). Una ley comunitaria, que entraba en vigor en el año 2016, que pretende garantizar la protección de datos de la población a través de restricciones sobre el uso de datos personales y la recopilación de información sin el consentimiento explícito de los usuarios. Un reglamento que ha impedido, entre otras cosas, el desembarco de Apple Intelligence a la Unión Europea cuando en otros mercados internacionales llevan ya varios meses trabajando con ella.

Los guardianes de la verdad y la situación en España

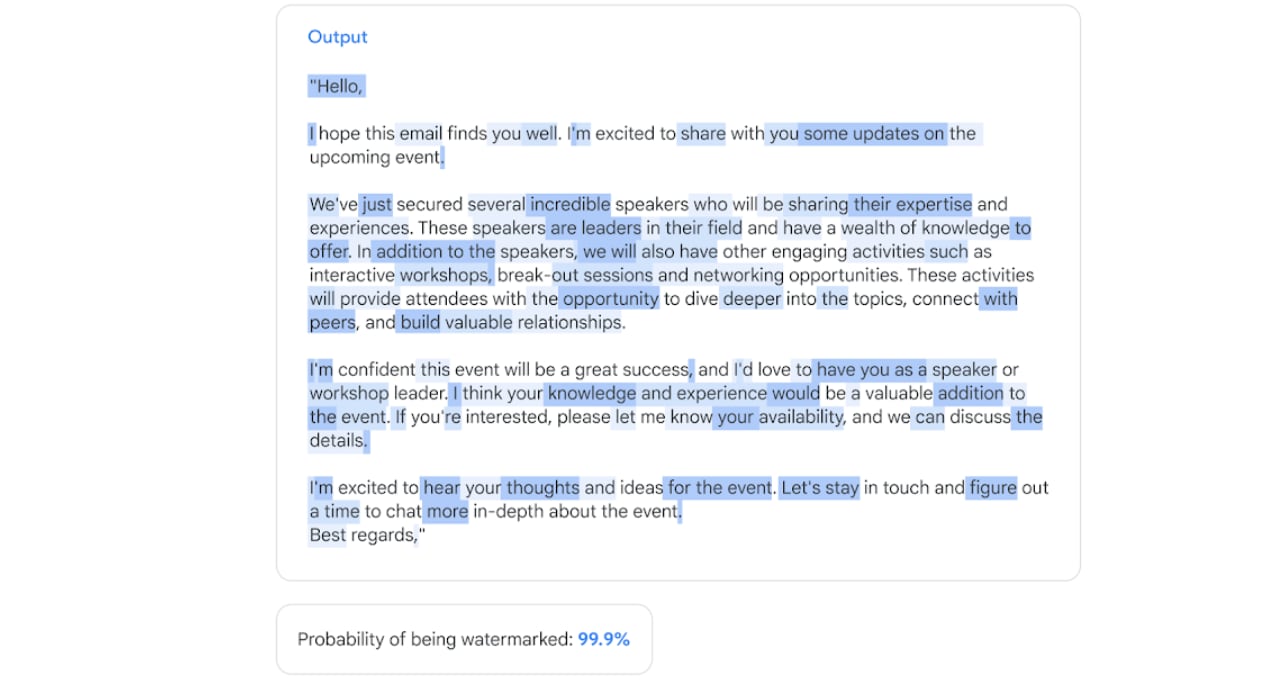

Dado que universalizar este estándar puede ser un proceso lento y complicado, cada una de las compañías que forman parte de este conglomerado busca sus propias soluciones con el objetivo de crear su propio estándar. Una de ellas es la propia Google, quien lanzaba algo más de un año una solución que se asemeja considerablemente a la propuesta de la C2PA. Un algoritmo, conocido como SynthID, que identifica y marca contenido generado por inteligencia artificial para que podamos conocer de dónde procede mediante un software concreto. El problema de esta herramienta es que de momento solo funciona con imágenes generadas a partir de Google DeepMind, por lo que no puede rastrear contenido creado por otras plataformas como MidJourney, DALL-E o Stable Diffusion, entre otras.

SynthID es capaz de realizar marcas de agua en los textos. / Google

SynthID es capaz de realizar marcas de agua en los textos. / Google

Por otro lado, otras compañías como Truepic se encargan de verificar imágenes digitales para garantizar su autenticidad. Todo ello a través de una plataforma conocida como Truepic Vision, mediante el que la compañía adquiere los datos de procedencia de un contenido y utiliza criptografía para protegerlo de cualquier posible alteración antes de que llegue a su destinatario final. De esta manera, la compañía propone verificar la autenticidad del contenido desde el momento en el que se captura, lo que permitiría distinguir un contenido falso de otro real. A nivel global han surgido muchas otras herramientas más como FakeCatcher o Sentinel, especializadas en el reconocimiento tanto de imágenes como de vídeo desarrollado por inteligencia artificial. Mientras que la primera analiza el "flujo sanguíneo" en los pixeles de un video en concreto para determinar si es real o generado por la inteligencia artificial, el segundo analiza los gestos de los protagonistas de los mismos para salir de dudas.

¿Y cuál es la situación en España? A día de hoy no nos enfrentamos a la cantidad de deepfakes que podemos encontrarnos en otros países como Estados Unidos o Venezuela, por poner varios ejemplos. No obstante, durante estos últimos meses han surgido proyectos que pretenden ayudarnos a determinar si un contenido es real o no en cuestión de segundos.

El caso de VerifAI

Uno de ellos es VerifAI, plataforma desarrollada por Telefónica que nace con el objetivo de detectar contenido tanto generado como modificado por inteligencia artificial. Desde imágenes y vídeos hasta audios de todo tipo. En declaraciones a la Cadena SER, la Head of Telefónica Venture Builder, Susana Jurado, nos explica que esta herramienta se apoya en varios motores que son capaces de identificar diferentes formas de actuar de una inteligencia artificial cada vez que manipula o genera contenido: "Lo que buscamos son patrones en las imágenes, artefactos distintivos o características típicas de las imágenes creadas por inteligencia artificial que nos ayuden a salir de dudas".

La imagen de Kamala Harris era, para sorpresa de nadie, falsa. / Cadena SER

La imagen de Kamala Harris era, para sorpresa de nadie, falsa. / Cadena SER

Entre otras cosas, estos motores se encargan de analizar la manera en la que el protagonista del vídeo pestañea. También se fija en otros detalles como el seguimiento de su mirada, los colores utilizados en la escena en cuestión o incluso las posición de la cabeza: "Al final es una suma de muchas técnicas". Después de recabar todos estos datos, la plataforma nos puede dar con una respuesta de lo más contundente. Una vez completado el análisis, la herramienta te ofrece un resultado porcentual que te señala la probabilidad de que dicho contenido haya sido creado a partir de la inteligencia artificial.

Sin embargo, Susana Jurado nos explica que tienen que estar constantemente entrenando estos motores para que puedan crecer al mismo ritmo que lo hace la inteligencia artificial. Gracias a ello, la herramienta es capaz de detectar técnicas más sofisticadas y continuar distinguiendo un contenido real de otro falso: "Todos los meses reentrenamos los modelos porque el avance de la inteligencia artificial es vertiginoso".

VerificAudio como herramienta periodística

Por otro lado, VerificAudio es una herramienta periodística de PRISA para la detección de audios falsos. Una plataforma, dirigida a las redacciones de los distintos medios de comunicación, que pretende ayudar a los periodistas a descubrir si el audio que han recibido es real o si ha sido desarrollado de forma sintética. Así nos lo explica la CDO Radios de PRISA Media, Ana Ormaechea, quien reconoce que el reto al que nos enfrentamos no para de hacerse más y más grande: "Para el oído humano es cada vez más complicado diferenciar una voz real de una clonada porque la tecnología va mejorando y se ha democratizado".

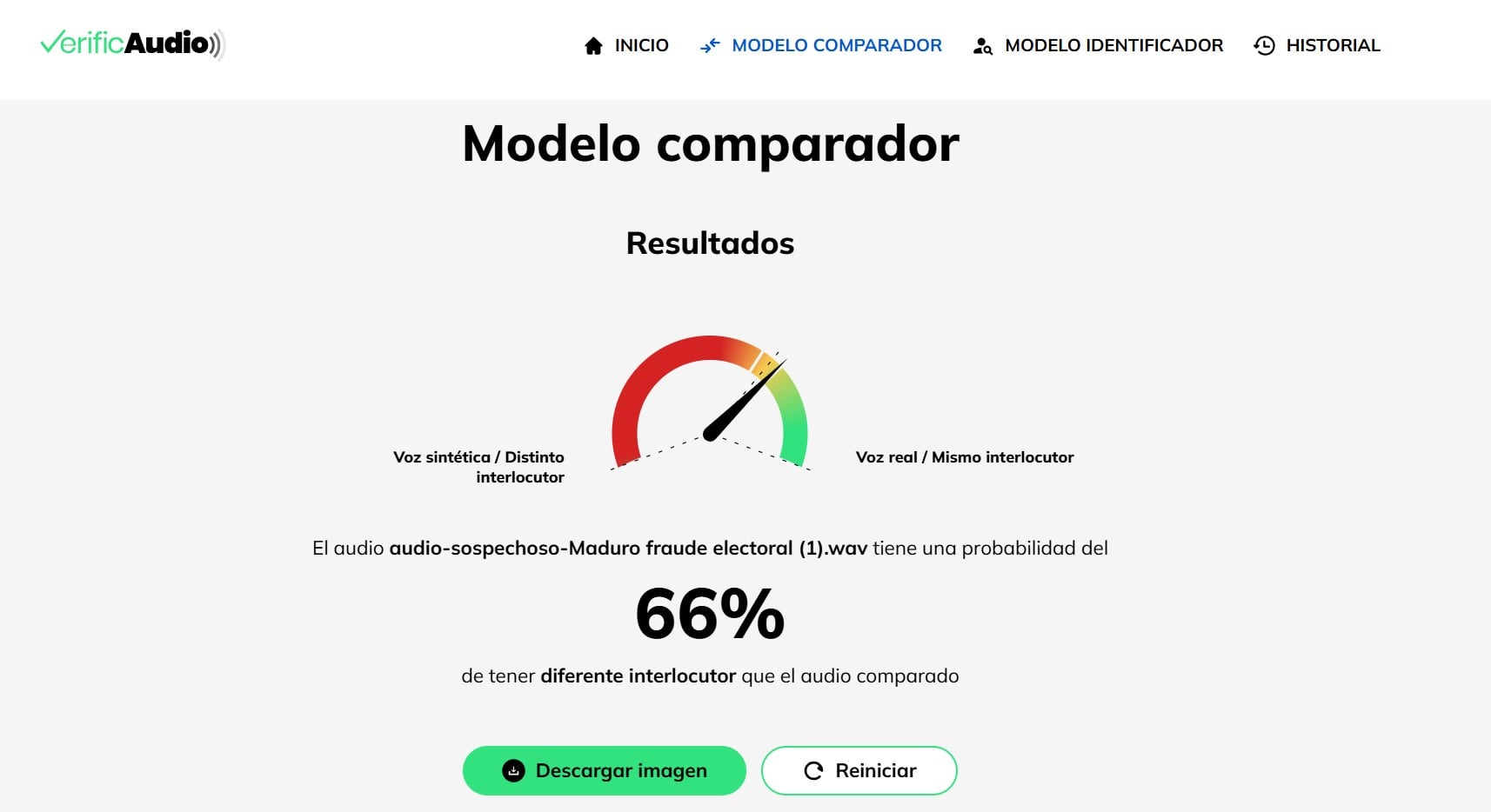

En esta ocasión, la herramienta se basa en dos modelos de inteligencia: uno comparativo y otro identificador. El primero de ellos se encarga de comparar las voz del audio con la del personaje al que trata de suplantar para determinar si son la misma en base a varios parámetros. El segundo es un machine learning que te detecta manipulación sobre las cualidades físicas del audio: "Desde la tonalidad hasta la frecuencia o el ritmo. Hemos establecido un total de ocho y sobre estas variaciones señala si realmente ha habido una manipulación de esas cualidades o no".

El audio de Nicolás Maduro ha resultado ser falso. / Cadena SER

El audio de Nicolás Maduro ha resultado ser falso. / Cadena SER

Durante estos últimos meses, la plataforma ha resultado clave para identificar casi un centenar de audios falsos que comprometían a personalidades como la anteriormente citada Claudia Sheinbaum o Nicolás Maduro. Audios que provenían principalmente de países como Argentina, Chile o Colombia, que incidieron principalmente en Venezuela. Concretamente en la figura de Nicolás Maduro, pues llegaron a descubrir hasta cinco audios falsos sobre el presidente del país. Después de subir los audios a la plataforma, estos se han encargado de analizar los distintos parámetros establecidos y establecer que no eran más que ejemplos claros de deepfake que tenían como objetivo engañar o incluso desestabilizar a terceras personas.

El análisis muestra dos voces distintas. / Cadena SER

El análisis muestra dos voces distintas. / Cadena SER

El punto de inflexión

El año 2024 ha marcado, sin duda alguna, un punto de inflexión en cómo la inteligencia artificial y los deepfakes pueden influir en los procesos democráticos a nivel global. De ahí la importancia de desarrollar una resistencia tecnológica capaz de contrarrestar este tipo de contenidos falsos que tienen como objetivo desestabilizar. Necesitamos herramientas de carácter inmediato y encontrar una solución común a nivel global. En este sentido hace falta una colaboración de carácter internacional en la que todos puedan sumar a la causa. Desde los propios gobiernos hasta las empresas o incluso la ciudadanía, quienes deben formar una alianza sin precedentes para poder hacer frente a un problema que a cada día que pasa se hace más y más grande.

Por otro lado, es importante educar a la sociedad sobre los peligros que entraman el mal uso de la inteligencia artificial y los deepfakes, tal y como nos recuerda Daniel Palacios del Río: "La educación es clave para mitigar los riesgos asociados al mal uso de los deepfakes. Esto incluye informar al público sobre cómo identificar contenido manipulado, fomentar el pensamiento crítico y promover una cultura digital responsable". Solo así, y gracias a la conciencia colectiva, podremos dar ese paso adelante para poder impulsar estas políticas que sin duda alguna ayudarían a frenar el auge de estos deepfakes.

David Justo

(Astrabudua, 1991) Periodista especializado en tecnología que aborda la vida digital desde otro punto...